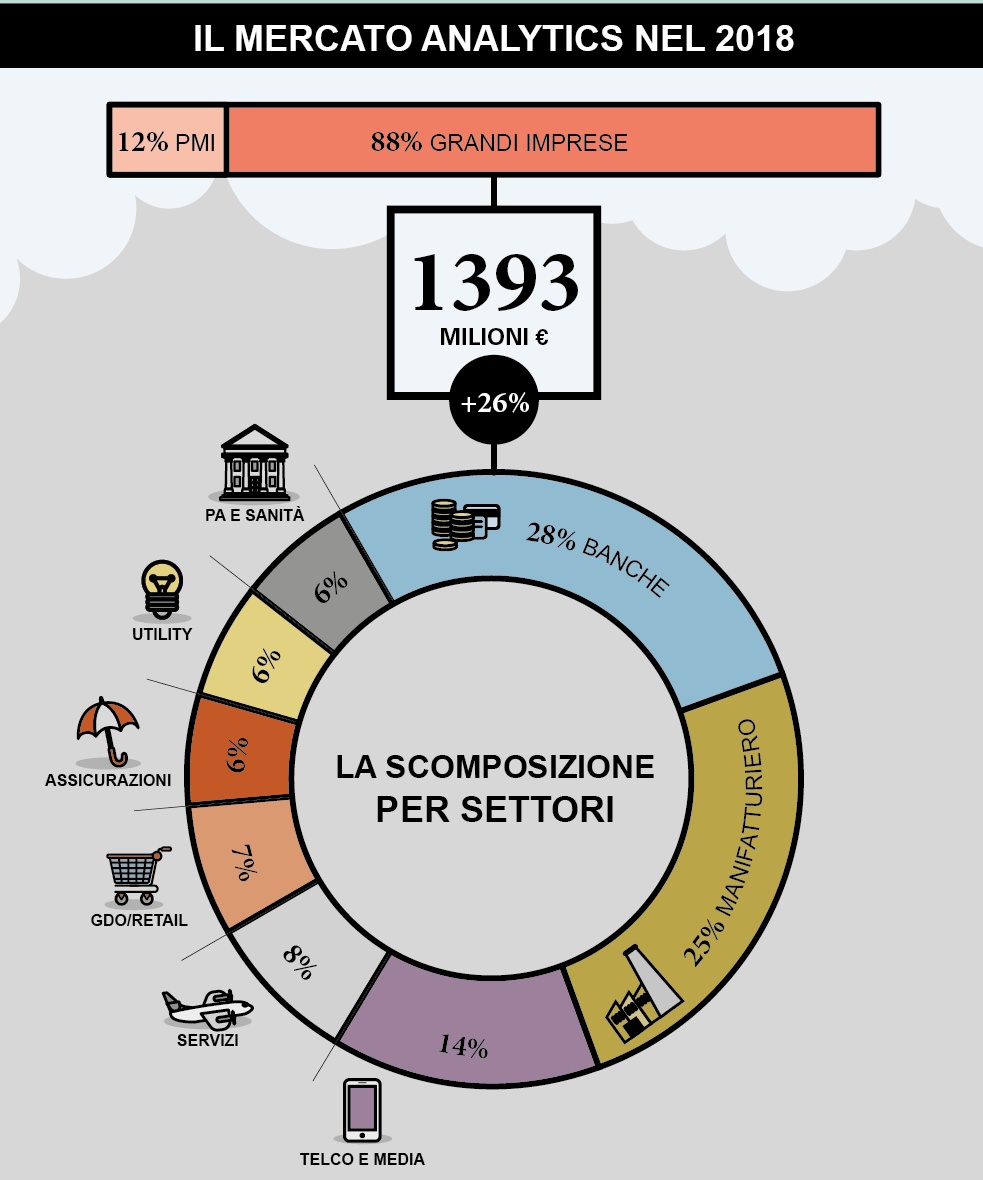

Il mercato italiano dei Big Data Analytics ha continuato il proprio trend di crescita nel 2018, raggiungendo un valore complessivo di 1,393 miliardi di euro, pari a + 26% rispetto all’anno precedente.

Il 45% della spesa in Analytics è dedicata ai software (database e strumenti per acquisire, elaborare e analizzare i dati…), il 34% ai servizi (personalizzazione dei software, integrazione con i sistemi informativi aziendali) e il 21% alle risorse infrastrutturali (capacità di calcolo, server e storage).

Mercato dei Big Data Analytics 2018 – Fonte Osservatorio Big Data Analytics & Business Intelligence della School Management del Politecnico di Milano

L’evoluzione del mercato dei Big Data Analytics va ben oltre i numeri, cambiano le metodologie di analisi, cresce l’esigenza di competenze di data science: il 46% delle grandi imprese ha già inserito figure di Data Scientist in organico, il 42% Data Engineer, il 56% Data Analyst. Nonostante questo, però, più della metà (55%) presenta un modello organizzativo ancora tradizionale.

Questi sono alcuni dei dati che emergono dalla ricerca dell’Osservatorio Big Data Analytics & Business Intelligence della School Management del Politecnico di Milano.

La totalità delle grandi organizzazioni adotta Analytics di tipo descrittivo, ma molte stanno sperimentando un’evoluzione verso logiche di predictive, prescriptive e, in alcuni casi, automated Analytics. L’evoluzione passa attraverso tecniche di Machine Learning e Deep Learning, che abilitano nuove tipologie di analisi, e di Real-time Analytics.

Il 62% delle grandi aziende dichiara di avere necessità di competenze specifiche di Machine Learning e Deep Learning: tra queste, poco più di un terzo le ha già introdotte in organico e un ulteriore 30% prevede di farlo nei prossimi due anni.

Poco più di un’azienda su dieci (11%) invece sfrutta oggi modalità di analisi in Real-Time o in Streaming, in cui vi è un flusso continuo di raccolta dei dati che devono essere analizzati con continuità. Un ulteriore 33% possiede un’infrastruttura che consente analisi in Near Real-Time, con una frequenza d’aggiornamento che scende a meno di un’ora. Il 56% delle organizzazioni analizza i dati in modalità batch, con un aggiornamento del sistema a intervalli regolari e predefiniti (solitamente giornalieri).

Nonostante siano diminuite complessità e incertezze nel percorso di adozione di progetti di Analytics, rimangono alcuni ostacoli da superare.

Le difficoltà maggiori riguardano la mancanza di competenze e figure organizzative interne (53%), l’integrazione dei dati (45%) e la stima dei benefici dell’investimento (34%). Seguono la mancanza di coinvolgimento del management (27%), la necessità di investimenti troppo elevati (22%), la difficoltà nel reperire dall’esterno professionalità con competenze adeguate (18%), la scarsa qualità e affidabilità dei dati (18%) e le difficoltà nell’impiego di software e altre tecnologie (14%).

Infine, nonostante il 2018 sia stato l’anno in cui il General Data Protection Regulation (GDPR) è diventato applicabile, solo il 10% del campione ha segnalato problemi di sicurezza e privacy.